ISACA Journal | 如何防范员工使用GenAI的隐私风险:以ChatGPT为例

由OpenAI开发的ChatGPT于2022年底向公众开放使用后,迅速成为历史上应用最广泛、用户数量增长最快的消费者应用程序,产品发布两个月内吸引了1亿活跃用户。ChatGPT既是一个大语言模型(LLM),也是一个使用机器学习(ML)算法和深度学习来分析公共领域各种数据库中大量数据的生成式AI应用。作为大语言模型,ChatGPT经过大量文本数据训练,并结合监督和非监督学习模型,为用户提供响应。

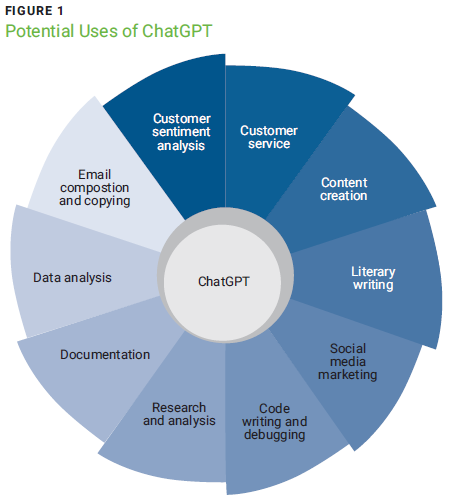

ChatGPT以其在不同场景中生成近似人类的响应能力而著称,并能根据用户输入的上下文生成相关回复。图1体现了一些潜在用途。

企业正迅速采用ChatGPT优化现有服务并推出新的服务。它能够通过自动化提高生产力和效率,通过提供竞争优势创造价值。此外,员工甚至在未经雇主正式授权的情况下使用ChatGPT解决复杂任务。

.jpg)

ChatGPT的广泛采用带来了安全和隐私方面的担忧。尽管ChatGPT为企业和个人提供了无数优势,但应该充分评估其安全和隐私影响。此外,如果员工使用AI聊天机器人,雇主应实施有效的信息安全控制和数据保护措施,并监控和评估这些控制措施的设计和运行效果,以确保符合安全政策、合同义务和隐私法规的遵从性。

ChatGPT带来的安全与隐私风险

用户需要向ChatGPT提出相关问题以生成所需内容。当用户向ChatGPT输入数据时,实际上他们正在提供可供OpenAI使用的数据。根据ChatGPT的使用条款,OpenAI有权使用输入的内容和ChatGPT的输出内容来维护、开发和优化其服务,用户需确保提供给聊天机器人的内容符合适用的法律法规要求。

OpenAI不会通过应用程序编程接口(API)输入或收到的内容开发或维护服务,但可能会根据其使用条款,使用非API服务的内容。使用非API服务内容的用户必须正式选择退出,不授权OpenAI使用其内容进行服务的维护和提升。值得关注的是,选择不使用数据进行服务提升,并不一定能避免数据泄露。目前,ChatGPT托管于美国,可能会根据其隐私政策,使用提供的个人信息维护或分析服务,开发新的解决方案和服务,并进行研究。此外,OpenAI可能会在不明确告知数据主体的情况下,依据其有关个人信息披露的隐私政策,向第三方提供个人信息。企业应对这些隐私政策和使用条款充分评估。

与ChatGPT交互时,员工可能无意中共享了机密信息,如机密商业数据、商业秘密和客户个人信息,包括健康相关信息,这些信息的安全性可能无法保证。此外,因为ChatGPT使用机器学习算法和深度学习分析公共领域中的大量数据,员工可能会收到作为内容输出的专有信息,从而为雇主带来法律风险。

如果员工向ChatGPT输入与雇主商业策略、IT策略或市场营销策略相关的数据,可能存在一种风险:为员工生成的内容可能被用来为竞争对手制作类似的内容;这些信息可能具有重大的商业价值并影响市场份额。2023年1月,一个名为Fishbowl的在线专业网络应用程序开展的调查发现,68%的员工是在他们的直线经理和雇主不知情的情况下使用 ChatGPT的。

2023年3月,OpenAI因一个软件漏洞,导致ChatGPT暂时下线。该漏洞允许一些活跃用户查看其他用户的聊天记录。OpenAI认为,同一个漏洞可能导致持卡人数据泄露,某些活跃用户可能查看到其他用户的姓名、电子邮箱地址、信用卡类型、信用卡有效期、账单地址以及卡号的后四位,尽管完整的信用卡号码未被泄露。据OpenAI称,该软件漏洞已被解决,并已实施了额外的软件安全控制措施。

2023年3月三星电子发生了三起涉及其机密信息泄露的事件,其员工向AI驱动的聊天机器人输入了半导体设备测量数据、软件程序代码及公司会议的要点。这些信息可能已成为ChatGPT学习数据库的一部分,因此可能对所有用户开放。值得一提的是,OpenAI建议用户在使用ChatGPT平台时不要共享敏感信息,因为无法从用户的对话历史中删除特定提示。Cyberhaven的研究发现,员工提供给ChatGPT的内容中有11%包含敏感数据;此外,2023年每10万名受访员工中有199起机密商业信息以及173起客户数据上传到平台的事件。

缓解使用ChatGPT的安全和隐私风险

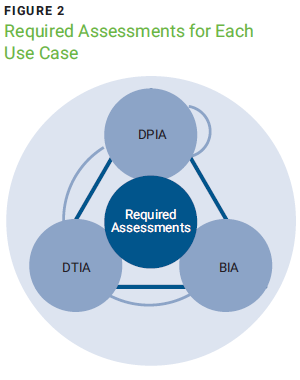

虽然ChatGPT可能给企业带来竞争优势并加快某些任务的执行速度,但选择采用AI技术的企业应实施有效的安全控制措施,以保护其信息的保密性、完整性和可用性(CIA)。为减轻潜在风险,企业应确定哪些业务功能需要使用生成式AI(如ChatGPT),包括相应的用例和特定过程,以及被允许使用AI聊天机器人的功能。对于企业而言,建议在实施前对每个用例开展充分风险评估,识别潜在的风险因素,确定相应的风险等级,并实施缓释控制措施以增强数字信任。除了安全风险评估之外,建议进行如下评估(见图2):

-

数据保护影响评估(DPIA)

-

数据传输影响评估(DTIA)

-

业务影响分析(BIA)

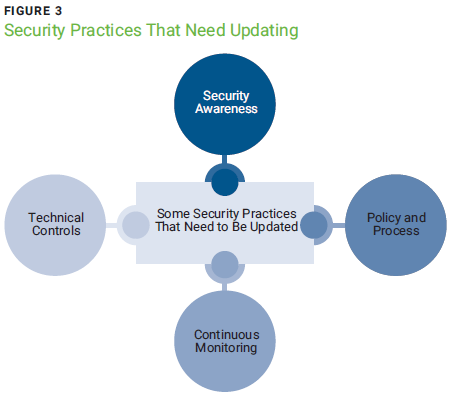

开展DPIA使企业能够评估是否现有的数据保护协议足以覆盖与新用例相关的数据处理活动。针对新用例中的数据传输场景,对标现有的DTIA,确保新用例已充分评估法律和监管要求,符合当地的数据保护法规。更重要的是,当与AI聊天机器人的互动涉及个人数据使用时,需要尊重数据主体的权利,符合数据收集地点适用的数据保护法规。此外,还必须评估现有的BIA,以确保周密考虑新用例对企业、员工、合作伙伴、合同义务各方和其他利益相关者的影响。例如,为使ChatGPT的使用更加安全,企业可能需要重新思考或重塑现有的信息安全实践和控制措施。图3展示了企业需要更新的一些实践。

安全意识

安全意识培训应包括对ChatGPT和其他生成式AI平台的可接受和禁止使用说明,以便员工了解潜在风险和与平台安全使用相关的责任。企业应将安全意识培训置于优先级,并为使用AI聊天机器人的员工提供针对性培训;但同时,企业也需要确保开展全面的安全意识培训,向不使用生成式AI的员工介绍如何保护他们的数据,以及因工作目的使用而被禁止的原因及方式。员工使用ChatGPT所带来的安全和隐私风险,使得雇主和数字信任从业者需要重新设计安全意识培训,增加培训频率,定义衡量效果指标,并监控这些指标以实现持续改进。

政策与流程制度更新

企业需要更新安全政策,包括使用ChatGPT和其他生成式AI平台产生的风险因素,其中包括:

-

更新可接受使用政策,包括生成式AI的使用,或者为特定用户和普通员工定义和实施生成式AI使用政策

-

更新第三方供应商政策

-

更新事件响应计划

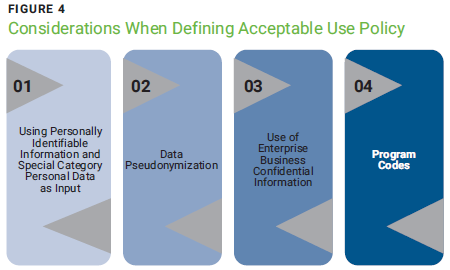

企业应考虑在工作场所定义和实施生成式AI(包括ChatGPT)的可接受使用政策(见图4)。为员工提供清晰的指导方针,增强他们在使用AI平台时的信心。定义和实施针对生成式AI可接受使用的政策,可降低隐私和安全漏洞发生的可能性。OpenAI无法控制员工向ChatGPT输入的信息,因此雇主必须确保员工以支持企业目标为导向使用平台,同时将数字信任置于与AI聊天机器人的所有互动的中心。在应用程序的登录页面突出显示ChatGPT的可使用范围,并明确要求员工在使用应用程序之前同意使用政策,提醒他们将此作为安全义务。每次员工同意继续进行时,都被记录下来,以便进行记录留存和调查目的。尽管企业可能制定和实施安全措施旨在减轻因使用ChatGPT产生的风险,但如果第三方服务供应商不受类似政策的约束,可能会导致数据泄露,从而使企业遭受损失。企业需要确保供应商披露他们是否使用ChatGPT或其他生成式AI平台作为提供服务的工具和流程。这些供应商应被要求验证安全尽职调查,并更新其合同安全计划以包含与生成式AI软件使用相关的条款。企业可能需要更新与第三方的数据处理协议,以包含有关供应商是否可以在ChatGPT上输入所处理数据的条款。此外,与第三方供应商签署的保密协议(NDAs)也需要进行相应更新。当前企业需要对第三方供应商进行评估,以确定其是否使用生成式AI以及其使用程度,并与之建立具有合法约束力的合同和保密协议,以确保数据的机密性、完整性和可用性。企业还必须更新现有的计算机安全和事件响应计划,包含由员工使用ChatGPT引起数据泄露的应对方法,并定期进行桌面演习以测试这些计划。

技术安全控制

关于技术控制方面,企业可以考虑实施图5所示的技术控制。在ChatGPT应用程序中禁用上传功能可以限制员工向平台提供信息,从而降低安全风险。尽管ChatGPT的API版本看起来更安全,但并非所有企业都能够实施。使用基于Web版本的企业应考虑默认禁止使用生成式AI,并仅允许因工作需要在群组策略级别访问该平台。此外,企业还可以在其内网范围内实施ChatGPT。此外,企业应考虑实施基于角色的访问控制(RBAC)以限制员工对ChatGPT的访问。只有那些工作需要使用该平台的员工才能访问,而且只有在员工接受了平台使用专门的安全意识培训并表现出对其可接受使用政策的理解后,才能获得访问权限。企业还可以考虑将ChatGPT与他们的单点登录(SSO)和多因素认证(MFA)系统集成。安全信息和事件管理(SIEM)监控以及安全和隐私审计可用于监控政策违规行为。ChatGPT或其他生成式AI平台也可以与现有的SIEM监控集成,并设置触发器,以便在授权用户与AI平台交互,共享机密信息时向监控团队发出警报。最后,企业应对ChatGPT的使用进行安全和隐私审计,以确定潜在的政策违规以及安全和隐私风险因素。

结论

虽然企业在采用ChatGPT和其他生成式AI时可以获得巨大的竞争优势,但也可能会面临重大的隐私风险,包括违反法律法规。企业必须对他们打算实施的每个用例进行风险评估,并实施适用的安全控制以减轻隐私和监管风险。此外,安全从业者在利用ChatGPT和其他生成式AI获取竞争优势时,必须重新设计和创新现有的安全控制以维护企业的数字信任。

编者注:本文出自ISACA Journal 2023年第6期。尾注略。文章内容仅代表作者本人观点。。

作者:OLUWAFEMI ADEYEMO ADELEKE, CISA, CISM, CGEIT, CRISC, CDPSE,3DMA CONSULTING LIMITED的董事和首席顾问,也是一名网络安全顾问。

翻译:吴梦庭(TIFFANY WU),ISACA微信公众号特邀通讯员。

校对:唐雅琪(ANDREA TANG),FIP, CIPP/E, CIPM,ISO 27001 LA,ISACA微信公众号特邀通讯员小组组长。

.png)